| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

- SegFormer

- hypergraph

- TAAM

- ConvNeXt

- Tissue segmentation

- Cell-tissue

- Referense Super Resoltuion

- GNN

- Cityscapes

- arbitrary scale

- implicit representation

- INR

- LIIF

- DIINN

- Super-Resolution

- ADE20K

- SISR

- Feature reuse

- Graph

- GNN in image

- TRANSFORMER

- graph neural network

- CrossNet

- Zero-Shot sr

- deep learning

- FRFSR

- Cell detection

- Reference Super-Resolution

- session-based recommendation

- Reference-based SR

- Today

- Total

딥러닝 분석가 가리

TTSR Paper Review 본문

"Learning Texture Transformer Network for Image Super-Resolution"

Abstract

SR(Super-Resolution)은 LR(low-resolution) 이미지로부터 texture를 현실적이게 복구하는것이 목표이며, 최근에는 Ref(reference) 이미지로 부터 정보를 받아 HR(high-resolution)을 만들고 있다. 하지만 이전의 SR들은 Ref 이미지로 부터 HR 이미지로 정보를 전송할때 attention 방법으로 사용하지 않는다. 그래서 본 논문에서는 LR과 Ref 이미지가 transformer에서 query와 key로 계산되는 TTSR(Texture Transformer network for imagte Super Resolution)을 제안한다. TTSR은 이미지 생성 작업을 최적화 하기 위해, DNN으로 learnable texture 추출 모듈, relevance embedding module(관련성 임베딩 모듈), texture 전송을 위한 hard-attention 모듈, 그리고 texture 합성을 위한 soft-attention 모듈, 4가지 모듈을 가지고 있다. TTSR은 LR과 Ref 이미지 간의 공통 feature를 학습하도록 설계되었고, x1 부터 x4까지 cross-scale이 가능하다. TTSR은 정량적, 정성적 결과에서 SotA를 달성했다.

1. Intorduction

SR은 화질이 좋지 않은 LR을 자연적이고 현실적인 HR로 복구하는것이 목표이며, 최근 SR은 화질을 더 좋게 개선했으며 이는 모바일 카메라, 디지털 TV, 의료영상, 위성영상에서 사용할 수 있다.

SR연구는 보통 SISR(Single Image Super-Resolution)과 RefSR(Referenced-based image Super-Resoluton)이 있다.

- 전통적인 SISR은 HR의 texture가 degrading 과정중에 과도하게 destructed 되어서 종종 blur한 결과를 나타낸다.

- 비록 GAN 기반의 SR이 이러한 문제를 완화 했지만, GAN은 hallucinations하고 artifacts한 결과를 나타낼 수 있다.

- Ref 이미지로 부터 HR texture를 제공받는 RefSR은 좀더 나은 결과를 보이지만, SotA 방법들이 texture 전송방법을 보통 직설적으로 보내어서 SR 결과가 좋지 않다.(그림 1)

이러한 문제를 해결하기 위해 이미지 생성을 최적화하는 4가지 모듈을 가진 TTSR을 제안한다.

- Learnable texture extractor

- end-to-end 학습동안 파라미터가 업데이트 된다.

- SR 도중에 attention mechanism을 적용하기 위해 생성되는 solid foundation인 LR과 Ref 이미지의 동일한 feature embedding을 할 수 있게 설계되었다.

- Relevance embedding module

- LR과 Ref 이미지 사이의 관련성을 계산한다.

- LR과 Ref 이미지에서 추출된 특징을 transformer의 query와 key로 공식화해서 hard-attention, soft-attention map을 얻는다.

- Hard-attention module, Soft-attention module

- Ref에서 HR 이미지를 attention map을 통해 백본에서 추출한 LR feature로 전송하고 융합한다.

TTSR은 Ref에서 LR 이미지로 관련성있는 texture를 찾고 전송해서 정확도를 향상시킨 방법이다.

게다가 feature 표현을 더 잘하기 위해 다른 scale에서 학습하는 texture transformer 형식의 cross-scale feature 통합 모듈을 제안한다.

TTSR의 기여는 다음과 같다.

- Image generation task에서 첫번째로 transformer를 적용시켰다.

- Image SR을 위한 4개의 모듈을 가진 texture transformer를 제안한다.

- Multiple texture transformer로 더욱 강력한 feature 표현을 배울수 있는 새로운 feature 통합 모듈을 제안한다.

2. Approach

TTSR, CSFI(Cross-Scale Feature Intergration module)

2.1 Texture Transformer

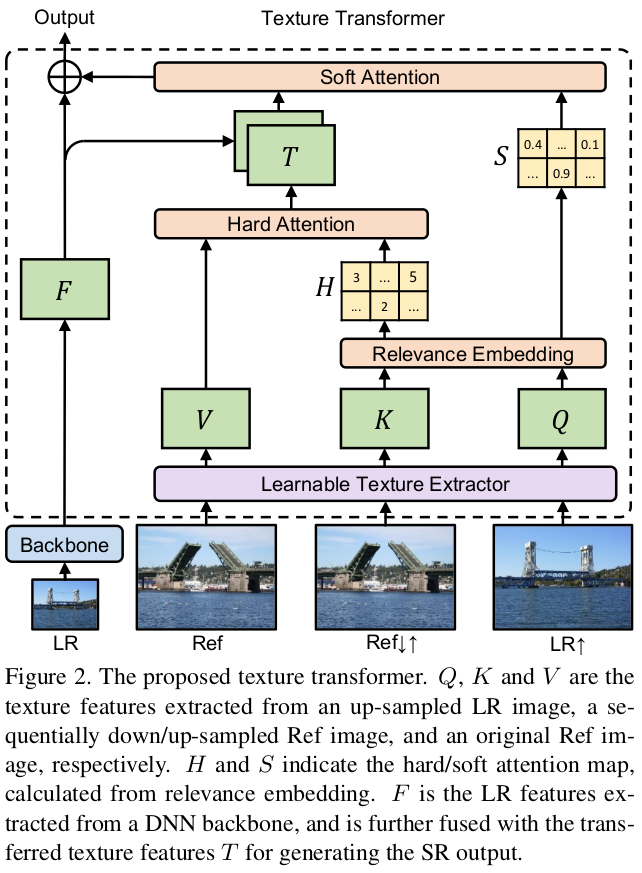

texture transformer의 구조는 그림2와 같다.

- LR, LR↑(x4 bicubic-upsampled), Ref가 입력 이미지이다.

- 순차적으로 Ref 이미지에 x4의 bicubic down-sampling과 up-sampling을 진행해 LR↑의 domain-consistent인 Ref↓↑을 얻는다.

- Texture transformer는 Ref, Ref↓↑, LR↑을 사용하고 LR feature는 백본으로 입력되어 만들어지고 HR 예측을 생성할때 사용될 synthesized feature map을 출력한다.

- Texture transformer에는 4가지 모듈이 있다.

- LTE(learnable texture extractor), RE(relevance embedding module), HA(hard-attention module for feature transfer), SA(soft-attention module for feature synthesis)

Learnable Texture Extractor

- 정확하고 적절한 texture 정보가 SR 이미지 생성에 도움을 줄 수 있기 때문에 Ref SR에서 ref 이미지의 texture를 추출하는것은 필수적이다.

- VGG와 같은 모델로 추출된 semantic feature를 사용하는것 대신에 end-to-end 학슴동안 parameter가 업데이트되는 LTE를 설계한다.

- 이러한 설계는 LR과 Ref 이미지에 걸쳐서 보다 정확한 texture feature를 capture할 수 있는 공동 feature learning을 장려한다.

- Texture 추출과정은 다음과 같이 표현 된다.

- LTE()는 learnable texture extractor의 출력을 나타낸다.

- 추출된 texture feature인 Q(qurey), K(key), V(value)는 transformer 내부의 attention-mechansim의 3가지 기본 요소를 나타내고, relevance embedding module에 사용된다.

Relevance Embedding

- Relevance embedding의 목적은 Q와 K 사이의 유사성을 추정해 LR과 Ref 임지 사이의 관련성을 embed하는것 이다.

- Q와 K를 patches로 펼친다. q_i (i ∈ [1, H_LR × W_LR]), k_j (j ∈ [1, H_Ref × W_Ref])

- 각 patch인 q_i는 Q, k_j는 K이고, 두 패치를 normalized inner product해서 relevance r_i,j를 계산한다.

- Relevance는 hard-attention과 soft-attention을 얻기위해 사용된다.

Hard-Attention

- Ref image로 부터 나온 HR texture feature V를 transfer 하기위해 hard-attention을 제안한다.

- 전통적인 attention mechanism은 각 query q_i에서 weight sum인 V를 얻지만, 이 연산은 transferring HR texture feature이 부족해 blur한 효과를 일으킬 수 있다.

- 그러므로 hard-attention 모듈은 각 쿼리 q_i에 대해 V에서 가장 관련성이 높은 position에서만 feature를 transfer한다.

- 먼저, hard-attention map 안에 있는 relevance r_i,j 로부터 계산된 i번째 원소인 h_i (i ∈ [1, H_LR × W_LR])를 계산한다.

- h_i 값은 i번째 position에 있는 LR 이미지의 가장 관련성 있는 Ref 이미지 position를 나타내는 hard index로 볼 수 있다.

- Ref 이미지로 부터 transferred HR texture features T를 얻기위해, hard-attention map을 사용해 V의 unfolded patches에 index selection 연산을 적용한다.

- t_i는 h_i 번째 위치의 V로부터 선택된 i번째 T 값이다.

- 그 결과 LR 이미지로 부터 soft-attention 모듈에 사용할 HR feature representation T를 얻는다.

Soft-Attention

- DNN 백본으로 부터 나온 LR 이미지의 LR feature F와 transferred HR texture feature T를 합성하기 위해 soft-attention 모듈을 제안한다.

- 합성 과정동안,관련있는 texture transfer는 덜 관련있는 것들이 되살려지는 대신에 개선되어 진다.

- 이것을 하기 위해서, soft-attentoin S는 T의 각 position의 transferred texture features confidence를 나타내기 위해 r_i,j로 부터 계산된다.

- s_i는 i번째 위치한 soft-attention map S 이다.

- 직접적으로 attention map S를 T로 적용시키는것 대신에, 먼저 LR 이미지로 부터 더 많은 정보를 활용하기 위해 HR texture features T 와 LR features F 를 fuse 한다.

- Fuse된 features는 element-wise하게 soft-attention map S에 의해 곱해지고 texture transformer의 마지막 출력을 얻기위해 F에 다시 추가 된다.

- F_out은 synthesized output feature, ⊙는 element-wise multiplication

Texture transformer는 Ref 이미지 안의 LR 특징으로 부터 relevant HR texture feature를 효율적으로 transfer 한다.

2.2 Cross-Scale Feature Integration

TTSR은 CSFI 모듈로 cross-scale 방식으로 쌓을수 있다.(그림 3)

- Staked texture transformer는 3가지의 해상도(x1, x2, x4)를 위해 합성된 feature를 출력한다.

- 3가지의 해상도는 LR 이미지 안에서 다른 크기의 texture feature가 fuse된 것이다.

- 다른 scale을 따라서 더 나은 representation을 배우기 위해, 다른 scale의 feature를 따라 정보를 교환하기 위해 CSFI(cross-scale feature integration)을 제안한다.

- CSFI 모듈은 LR feature를 다음 크기로(x1 -> x2, x2 -> x4) up-sampled 한다.

- CSFI 모듈에서 각 scale은 up/down sampling된 다른 크기의 exchanged feature를 받는다.(channel을 기준으로 concat)

- 그리고 나서 Convolution layer는 원본 channel의 수 에서 feature map을 만든다.

- CSFI는 더 powerful하게 feature를 representation 하므로 성능을 개선 시킨다.

2.3 Loss Function

Loss function은 3개를 사용하며 total loss는 다음과 같다.

Reconstruction loss

- C,H,W는 HR의 크기이다.

- 성능 면에서 더 선명하게 나타나고 L2 loss 보다 수렴이 더 쉬운 L1 loss를 사용한다.

Adversarial loss

GAN은 이미지를 더 선명하고 시각적으로 favorable하게 생성하므로 WGAN-GP를 사용한다.

- weight clipping을 대체하기위해 gradient norm penalization(규제)를 제안한다.

- 그 결과 학습이 더 안정적이고 성능은 개선된다.

Perceptual loss

영상의 품질을 개선시켜 주는 perceptual loss는 예측과 GT 사이의 feature space의 유사성을 개선하는것이 key idea이다.

- φ^vgg 는 VGG19의 i 번째 layer의 feature map 이고, (C_i, H_i, W_i)는 해당 layer의 feature map의 모양을 나타낸다.

- 두번째 part(+ 뒤)는 transferal(전이) perceptual loss 이다.

- φ^lte 는 j 번째 LTE layer에서 추출된 texture feature map이고, (C_j, H_j, W_j)는 해당 layer의 모양이다.

- T 는 transferred(전송된) HR texture feature이다.(그림 2에 나타남)

- Transferal perceptual loss 제약은 SR 이미지를 전송된 texture feature T 와 유사한 texture feature를 가지도록 예측한다.

2.4 Implementation Details

- LTE는 conv layer 5개와 pooling layer 2개를 포함해 3개의 다른 scale를 출력한다.

- 연산량을 줄이기 위해 relevance embedding은 가장 작은 scale에만 적용되어, 다른 scale로 propagate(전파) 된다.

- Discriminator는 BN(batch normalization)을 지운 SRNTT 네트워크를 사용한다.

- 훈련동안 데이터를 랜덤하게 수평, 수직으로 뒤집고(flipping), 90, 180, 270도 로 회전해 증강시킨다.

- 각 mini-batch는 40×40 크기의 9개의 LR patches를 포함하고, HR과 Ref는 160×160 크기의 patches 9개를 가진다.

- 각 loss 별 가중치 계수(weight coefficient)는 L_rec : 1, L_adv : 1e-3, L_per : 1e-2 이다.

- 최적화 함수는 Adam, 학습률은 1e-4, 반복횟수는 L_rec만 적용시켜서 2번 그리고 loss를 다 적용시켜서 50번 시행한다.

3. Experiments

3.1 Dataset and Metrics

- 훈련 데이터 : CUFED5(train), 평가 데이터 : CUFED5(train) Sun80, Urban100, Manga109를 사용한다.

- 결과는 YCbCr 색 공간에서 PSNR과 SSIM으로 평가된다.

3.2 Evaluation

TTSR을 SISR과 RefSR 방법들과 비교한다. 모든 실험은 LR과 HR 사이의 scaling factor는 x4로 한다.

Quantitative Evaluation

- 공정한 비교를 위해 SRNTT와 같이 모든 방법들을 CUFED5(train)로 훈련하고 CUFED5(test), Sun80, Urban100, Manga109로 평가한다.

- SR 방법의 경우 adversarial loss를 사용한 훈련은 일반적으로 더 나은 품질을 보이지만, PSNR과 SSIM값이 낮다는 사실이 있어, 공정한 비교를 위해 TTSR-rec라는 reconstruction loss만을 사용하는 훈련도 시행한다.

- 정량적 결과는 표1과 같으며 TTSR-rec가 가장 좋은 성능을 보인다.

- Adversarial loss를 같이 사용한 TTSR은 Sun80과 Manga109에서 좋은 성능을 보이고, 다른 두 데이터셋 CUFED5와 Urban100 에서는 다른 SotA 모델들과 비슷한 성능을 보인다.

Qualitative Evaluation

TTSR은 정성적 결과에서도 가장 좋은 품질을 보여준다.(그림 5)

- TTSR은 ref 이미지로 부터 더 정확한 HR texture를 전송할 수 있어서 favorable 결과를 생성한다.(1~3번째 줄)

- Ref 이미지가 입력 이미지와 global하게 관련이 없더라도 TTSR은 GT와 유사한 결과를 보여준다.(4~6번째 줄)

시각적 품질에 대해 다른 SotA 방법들과 TTSR 비교를 투표로 진행해서 비교한다.(그림 4)

- 90% 이상이 TTSR이 favorable한 시각적 품질을 나타낸다고 투표해 다른 SotA 방법보다 개선 되었다.

3.3 Ablation Study

TTSR을 다양한 방법(texture transformer, CSFI, L_adv, L_per)으로 효율적으로 검증하고, 다른 ref가 끼치는 영향에 대해 논의 한다.

Texture transformer

- Texture transformer는 4개의 모듈 : LTE, relevance embedding module, hard-attention, soft-attention을 가진다.

- Base(SRNTT에서 BN layer와 Ref 부분을 삭제한)에서 모듈 하나씩 추가해가면서 실험한다.

- 각 모듈을 추가할때 마다 PSNR이 향상되고 결과는 표 2와 같다.

- 그림 6에서는 SRNTT의 VGG19와 TTSR의 LTE를 비교한다.

- TTSR은 LTE를 사용해서 더 정확한 reference texture를 전송하고 globally favorable 결과를 생성한다.

Cross-scale feature integration

- CSFI는 다양한 해상도의 크기(x1, x2, x4)로 texture를 복구할 수 있다. CSFI의 ablation study는 표 3에 나타난다.

- 첫번째 행은 texture transfer만 사용, 두번째 행은 CSFI 사용, 세번째, 네번째 행은 texture transfer만을 사용했을때 channel의 수를 80 96으로 증가시킨 것이다.

- CSFI를 사용했을땐 PNSR이 "Base+TT"인 첫번째 행보다 0.17증가 했지만, channel의 수를 늘렸을때는 CSFI보다 성능이 낮고 parameter 수는 증가해, CSFI가 reference texture information을 효율적으로 사용하는것이 검증되었다.

Adversarial loss

- 모델을 설계하는것 보다 adversarial loss를 사용하는것이 영상의 품질을 개선시킨다.

- Base와 TTSR 그리고 이것에 오직 reconstruction loss만을 사용한 결과를 그림 7에서 비교한다.

Transferal perceptual loss

- Transferal perceptual loss는 예측된 SR 이미지와 transferred image T 를 유사하게 만든다는 제약이 있다.

- 그림 8에서 transferal perceptual loss를 사용한것과 안한것을 비교하며 사용한것의 영상 품질이 더 좋고, PSNR과 SSIM이 각각 25.20/0.757, 25.53/0.765 이다.

Influence of different reference similarity

- LR과 Ref 이미지 사이의 관계가 TTSR에 얼마나 영향을 끼치는지를 알아보기 위해 CUFED5로 실험 한다.

- 결과는 표 4에 나타냈고, L1은 가장 관계가 높은 ref image, L4는 가장 관계가 적은 ref image 이다.

5. Conclusion

- 본 논문에서는 Ref에서 나온 HR texture를 LR 이미지로 전송하는 TTSR(Texture Transformer Network for Image Super-Resolution)을 제안한다.

- 제안된 texture transformer는 Ref image로 부터 HR texture를 전송하는 두개의 attention 기반의 모듈과 attention 연산을 위해 공동의 feature embedding을 배우는 LTE로 구성된다.

- 게다가 제안된 texture transformer는 더 powerful한 feature representation을 배우는 CSFI로 cross-scale 한다.

- 실험 결과에서 TTSR이 SotA인것을 증명했고, 미래에는 texture transformer가 일반적인 image generation task가 될거다.

'딥러닝 논문 리뷰' 카테고리의 다른 글

| RZSR with Depth Guided Self-Exemplars Review (0) | 2023.02.02 |

|---|---|

| Online Learning for Reference-Based Super-Resolution Review (0) | 2023.01.31 |

| Robust Reference-based Super-Resolution with Similarity-Aware Deformable Convolution Paper Review (0) | 2023.01.14 |

| MZSR Paper Review (1) | 2023.01.11 |

| Zero Shot SR review (0) | 2023.01.03 |