| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

- DIINN

- Cell-tissue

- Super-Resolution

- LIIF

- deep learning

- CrossNet

- Tissue segmentation

- TRANSFORMER

- Reference-based SR

- Cell detection

- Cityscapes

- implicit representation

- TAAM

- Reference Super-Resolution

- Feature reuse

- GNN

- SISR

- graph neural network

- arbitrary scale

- INR

- Zero-Shot sr

- session-based recommendation

- ADE20K

- Referense Super Resoltuion

- GNN in image

- Graph

- ConvNeXt

- hypergraph

- FRFSR

- SegFormer

- Today

- Total

딥러닝 분석가 가리

Adversarial Text Image Super-Resolution Using Sinkhorn Distance Review 본문

Adversarial Text Image Super-Resolution Using Sinkhorn Distance Review

AI가리 2023. 4. 20. 23:36"Adversarial Text Image Super-Resolution

Using Sinkhorn Distance"

Abstract

Convolutional nerual network 기반의 방법들은 SISR에서의 좋은 성능을 보인다는것을 증명했지만, text를 원본 처럼 나타내기에는 어려움이 있다. 그래서 본 논문에서는, supervision 방법인 Lp-norm을 사용하는것 대신에, 텍스트 이미지에서 의미있는 정보를 더 많이 보존 할 수 있는 새로운 방법을 제안한다. 새로운 방법은 적대적으로 학습된 feature 공간에서 정의된 Sinkhorn 거리와 기본 형태의 optimal transport를 결합한다. Sinkhorn 거리가 두 feature의 구성요소와 spatial locations 측명에서 두 특징 간의 유사성을 측정하기 때문에, 제안하는 지표는 네트워크가 최적화 되는동안 texture의 공간적 구조를 유지할 수 있다. 실험적 결과로 제안하는 모델의 정성적, 정량적 결과가 SotA보다 text dataset을 더 잘 구축 했다.

Introduction

CNN 기반의 SISR들이 좋은 성능을 보이지만, L1, L2 loss를 사용하므로 지나치게 부드러운 이미지를 생성해 visual quality가 떨어지게 된다. 이러한 부분을 완화하기 위해, perceptual loss와 adversarial loss가 제안되어 더 현실적인 결과를 만들었지만, 정확도를 떨어지게 한다는 단점이 있다.

Text 이미지를 SR 하는것은, 기존의 natural 이미지를 SR 하는것 보다 수월하다. 예를들어, "CNN-based text image super-resolution tailored for ocr"에서는 VDSR 네트워크를 text SR에 사용한다. 해당 논문에서는 MSE loss와 padding을 사용해 SR을 수행한다. "Deep laplacian pyramid network for text images super-resolution"은 피라미드 네트워크 구조를 채택하고 pixel의 공간적 gradient 차이를 네트워크 최적화를 위한 기준으로 사용한다. 하지만, 이미지에 있는 text contents는 OCR, text detection, text understanding 분야에서 더 많은 정보를 제공한다. 일반적인 SR과 비교했을때 text image SR은 더 높은 정확도를 요구하므로 G가 C, Q가 O 가되는 의미가 변형되는것을 피해야 한다. 앞서 언급된 현재 존재하는 text SR은 pixel 영역에서 정의된 손실 함수에 의존하고 의미 변화에 대해 충분히 robust 하지 않다. 게다가 perceptual loss는 text의 의미론적 fidelity 대신 perceptaul 유사성을 보존하는것이 목표이므로 text에 효과적이지 않다.

본 논문에서는, 더 정확한 정보를 유지하기 위한 text SR frame work와 sr text와 hr text의 차이를 측정하는 새로운 지표를 제안한다. 저자는 정규화된 이미지를 고차원 공간의 이미지 모음이 아닌 분포로 공식화 한다. 이 지표는 adversarially 학습된 feature 공간에서 정의된 Sinkhorn 거리와 기본 형태의 optimal transport를 결합한다. Sinkhorn 거리는 feature 구성요소와 spatial location 측면에서 두 feature의 유사성을 측정해 네트워크 최적화 도중 텍스트의 공간 구조를 유지하는데 도움을 줄 수 있다. 실험 결과는 제안하는 방법이 정량적, 정성적 평가 모두 text SR 결과보다 나은것을 증명했다.

Optimal Transport and Sinkhorn Distance

Optimal transport는 data의 분포를 비교하는 강력한 도구이다. 이는 image processing, computer vision, machine learing 과 같은곳에서 많이 사용되었다. Wasserstein 거리는 optimal transport 이론을 기반으로 제안된 지표이다. 공식적으로, (M, d)를 M에 대한 모든 확률이 측정되는 공간이라고 하면 이는 Radon 측정(Radon space라고 불리는) 이다. p가 1 이상일때, Pp(M)가 M의 일부 x0에 대해 유한한 p 번째 모멘트를 갖는 M에 대한 모든 확률 측정 µ의 집합을 나타낸다고 하면 식 (1)과 같다.

Pp(M) 내의 측정된 두 확률분포 µ와 ν 간의 p 번째 Wasserstein distance는 식(2)와 같이 정의된다.

Γ(µ, ν)는 각각 첫번째와 두번째 요소인 µ와 ν 가장자리인 MxM에 대한 모든 측정값의 집합이다. Discrete optimal transport의 문제의 경우, empricial 분포 Pr과 Pg 사이인 1-Wasserstein 거리고 정의될수 있다.

<·, ·>F 는 Frobenius dot product를 나타낸다. C는 cost function matrix 이고 β는 두 empirical 분포 간의 확률적 결합 집합으로 식 (4) 처럼 정의된다.

Wasserstein distance의 이점은 픽셀의 강도와 위치에 따라 민감하다는 것이다. 표 1에서 보이는것과 같이, 만약 픽셀의 위치를 다시 shuffle 한다면, Euclidean 거리와 KL divergence는 여전히 변화되지 않고 이미지를 재구축한다. 오직 Wasserstein 만이 계산시 pixel의 위치를 사용하기 때문에 픽셀의 위치를 shuffle 했을때 변화한다. Wasserstein distance가 Euclidean distance나 KL divergence과 비교해 pixel의 기하학적 구조에 민감한 지표임을 발견했다. 하지만, Wasserstein distance를 다른 곳에 활용하기에는 계산적으로 부담이 되어 제한적이다. 이러한 제한을 완화하기 위해 Marco cuturi는 Wasserstein distance를 활용한 Sinkhorn을 제안했다.

다음 식 (6)은 β의 부분집합이다.

KL은 Kullback-Leibler divergence를 나타내고 h는 entropy 이다.

Wasserstein distance와 비교한 Sinkhorn distance는 low-cost joint 확률의 검색을 충분히 부드러운 table로 제한한다. Sinkhorn 거리를 계산하기위해 Lagrange 상수를 사용한다.

The Proposed Method

본 논문에서는 text SR을 위해 더 많은 text 정보를 가지고 resolution할 수 있는 새로운 loss function을 제안한다. 전체 네트워크 framework는 그림 1과 같으며 제안하는 optimal transport 기반의 새로운 지표는 text recognition에서 좋은 성능을 보인다.

Network Architecture

Backbone network로는 EDSR을 사용한다. EDSR은 resiudal block으로 layer를 깊게 쌓아 SR을 한 네트워크이다. SR의 성능을 올리기위해 BN을 삭제 하고 layer를 더 늘리는 대신 feature channel을 증가시켰다. Sinkhron distance의 text image resolution 성능을 확인하기 위해 EDSR과 같은것을 사용하고 residual scaling technique 또한 사용한다.

Adversarial Learning with Sinkhorn Distance

Super-resolved text image와 그들의 high-resolution 부분들 간의 차이를 측정하는 새로운 방법을 제안한다. 새로운 방법은 adversarially 학습된 feature 공간에서 정의된 Sinkhorn distance와 기본 형태의 optimal transport를 결합한다. GAN loss와 비교했을때 고차원의 공간에서 normalized image를 이미지의 모음이 아닌 하나의 분포로 간주한다. 저자는 Sinkhorn distance를 MSE loss 와 같이 loss function으로 사용한다. 만약 pixels의 위치 간의 Euclidean 거리를 transport cost function로 직접적으로 정의한다면, 높은 계산량을 요구할 것이다. 그래서 adversarially learned feature space에서 Sinkhorn 거리를 계산한다. 실제로, 저자는 이미지를 학습된 잠재 공간에 map하는 심층 신경망 φ를 사용한다. x를 sr image y를 hr image의 부분이라고 할때 두 네트워크로 부터 나온 값들을 비교하는 Sinkhorn distance는 식 (9)와 같다.

Γ λ는 optimal couplings 연산으로 "Learning generative models with sinkhorn divergences" 알고리즘 이고 C는 두 feature 간의 cost function이다.

훈련은 GAN의 네트워크와 유사한 적대적 훈련 protocol을 따른다. 먼저, 네트워크는 φ(x)와 φ(y) 간의 Sinkhorn distance를 최대화 되도록 업데이트 되어진다. 이 단계에서, 네트워크는 sr image와 hr image 간의 차이가 최대가 되도록 나타내는 feature space를 탐험한다. 다음, SR 네트워크의 MSE와 Sinkhorn distance loss가 최소화되도록 한다. 그래서 total loss는 MSE와 Sinkhorn distance loss를 더한 형태 이며 각 loss에 가중치, 하이퍼 파라미터를 곱해준다.

Experimental Results

- Dataset : ICDAR 2015 TextSR dataset

- HR-LR pair 567, GT OCR pair 141

- Cut HR image 18x18, Cut LR image 9x9

- Flips and Roataion as in the EDSR

- Optimizer Adam, Learning rate 0.001, Batch size 32

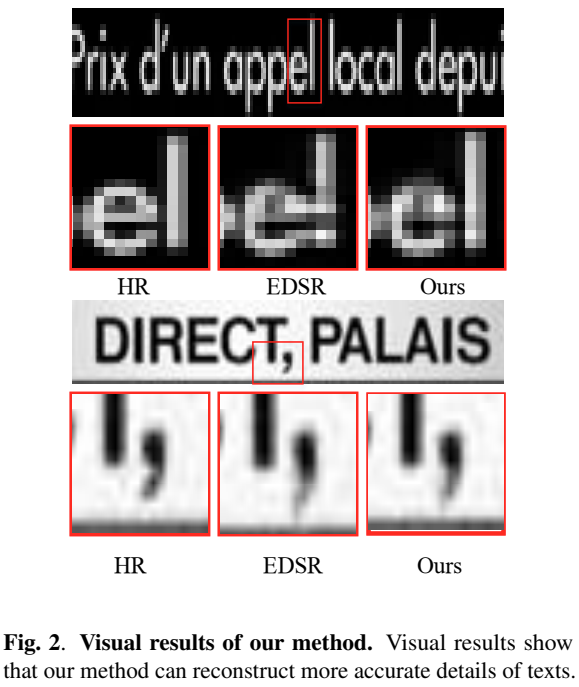

실험결과는 표 2, 그림 2, 표 3과 같으며 기존의 EDSR을 사용한것과 크게 차이가 나지 않는다. 하지만 정성적 결과인 그림 2의 경우 기존의 EDSR에 비해 feature 공간에 맞게 재구성 하므로 단어 'e'의 왜곡이 덜 하다.

Conclusion

- 본 논문에서는 text super-resolution을 위해 새로운 방법을 소개

- 방법은 Sinkhorn distance를 사용해 sr image와 hr image의 부분 간의 차이를 측정하는 방법

- 이것은 학습된 feature의 공간적 위치와 속성을 고려함

- 실험적 결과로 OCR 정확도가 가장 높게 나타남

Paper

https://ieeexplore.ieee.org/abstract/document/9054360

Adversarial Text Image Super-Resolution using Sinkhorn Distance

Convolutional neural network-based methods have demonstrated promising results for single image super-resolution. However, existing methods usually approach the problem on natural scenes rather than texts, whereas the latter can provide more informative me

ieeexplore.ieee.org

'딥러닝 논문 리뷰' 카테고리의 다른 글

| LDC: Lightweight Dense CNN for Edge Detection Review (0) | 2023.06.01 |

|---|---|

| Omni Aggregation Networks for Lightweight Image Super-Resolution Review (1) | 2023.05.29 |

| Graph Neural Network in Image (3) (0) | 2023.04.19 |

| Graph Neural Network in Image (2) (0) | 2023.04.05 |

| Graph Neural Network in Image (1) (0) | 2023.04.02 |